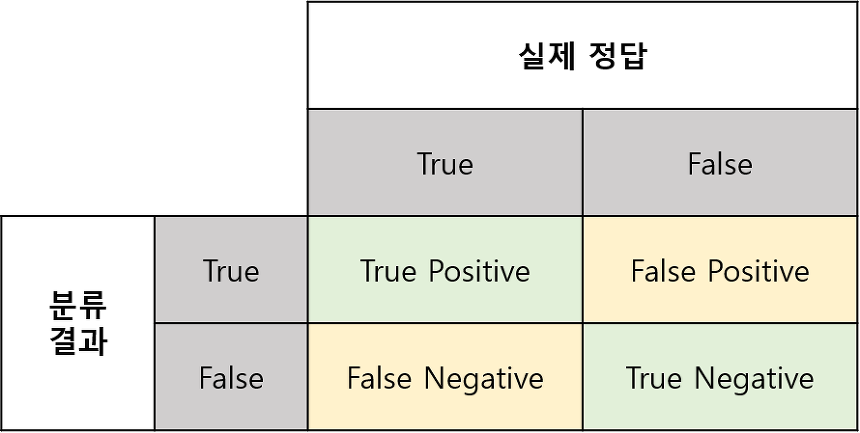

Confusion matrix

입력에 대한 실제 정답과 분류 결과에 대한 각 Case를 정리한 matrix

- True Positive(TP) : 실제 True인 정답을 True라고 예측 (정답)

- False Positive(FP) : 실제 False인 정답을 True라고 예측 (오답)

- False Negative(FN) : 실제 True인 정답을 False라고 예측 (오답)

- True Negative(TN) : 실제 False인 정답을 False라고 예측 (정답)

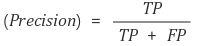

Precision

정밀도, 모델이 True라고 분류한 것 중에서 실제 True인 것의 비율

Recall

재현율, 실제 True인 것 중에서 모델이 True라고 예측한 것의 비율

Precision-Recall Trade-off

정밀도와 재현율은 Trade-off 관계에 있어서 둘 다 높히기는 힘들다.

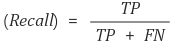

Type 1, 2 error

Confusion matrix에서 FN을 Type 1 error, FP를 Type 2 error 라고 한다.

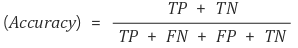

Accuracy

정확도, 가장 직관적으로 모델의 성능을 나타낼 수 있는 평가 지표로써 전체 중 맞게 예측한 경우를 따진다.

편향

전체 데이터가 불균형하여 한 쪽으로 치우쳐져, 예측하고자 하는 것에 대한 성능이 낮아지는 것

F1 score

Precision(정밀도)과 Recall(재현율)의 조화평균이다.

편향의 해결책

F1 Score는 데이터 label이 불균형 구조일 때, 모델의 성능을 정확하게 평가할 수 있으며, 성능을 숫자로 표현할 수 있다.

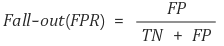

Fall-out

FPR(False Positive Rate)으로도 불리며, 실제 False인 data 중에서 모델이 True라고 예측한 비율, 즉 잘못 예측(분류)한 것

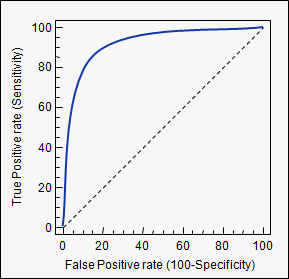

ROC curve

Receiver Operating Characteristic, 여러 임계값들을 기준으로 Recall-Fallout의 변화를 시각화한 것

성능 기준

curve가 왼쪽 위 모서리에 가까울수록 모델의 성능이 좋다고 평가한다. 즉, Recall이 크고 Fall-out이 작은 모형이 좋은 모형인 것이며, 또한 y=x 그래프보다 상단에 위치해야 어느정도 성능이 있다고 말할 수 있다.

AUC

Area Under Curve, ROC curve는 그래프여서 명확한 수치로 비교하기가 어렵기에 아래의 면적값을 이용한다.

Reference. https://sumniya.tistory.com/m/26

'나만 보는 정리노트 > Deeplearning' 카테고리의 다른 글

| ONNX(Open Neural Network Exchange) (0) | 2022.11.30 |

|---|---|

| 활성화 함수, Activation Function (0) | 2022.11.24 |

| ANN, DNN, CNN, RNN (0) | 2022.11.17 |